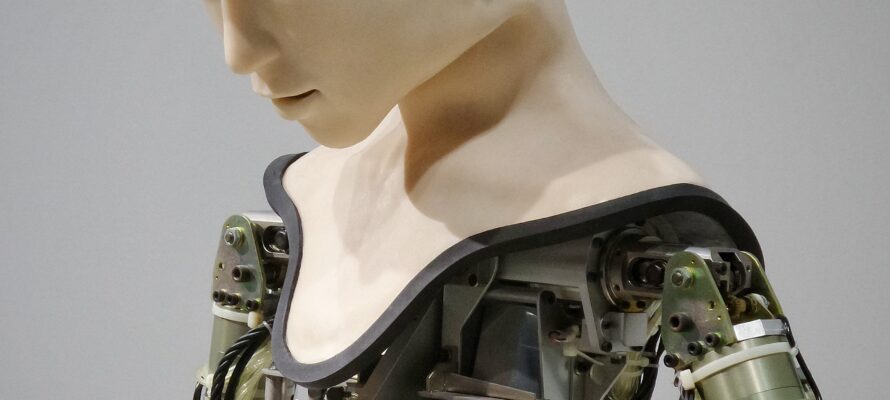

Inteligência Artificial de projeto do Facebook cria linguagem própria

Bots precisavam negociar entre si, porém encontraram atalhos de linguagem que não eram compreensíveis para humanos

O Facebook encerrou um projeto de inteligência artificial após este ter criado uma linguagem própria que não pode ser compreendida por humanos.

O programa foi desenvolvido pelo Facebook AI Research Lab (Laboratório de Pesquisa de Inteligência Artificial do Facebook, em tradução livre), divisão da empresa de Mark Zuckerberg que tem como objetivo desenvolver projetos relacionados ao conhecimento e desenvolvimento da tecnologia.

A ideia deste sistema em particular era simples: criar bots que conseguissem negociar trocas. Segundo o Facebook, dois “agentes” eram apresentados uma coleção de itens, como livros, chapéus e bolas, por exemplo, e tinham que negociar entre si a divisão deles.

Cada parte de interação valia alguns pontos. Se o agente quisesse muito um dos itens, o valor deste era alto, e se não chegasse em um consenso com o outro, não ganhava nenhum ponto. “Negociar é essencial e boa negociação resulta em uma boa performance”, escreve a empresa na explicação do sistema.

Os desenvolvedores estabeleceram alguns tipos de diálogos que os dois agentes teriam entre si. Conforme eles interagiam, no entanto, criaram uma linguagem própria que fazia as transações serem mais rápidas. “Não havia uma recompensa pelo uso da língua inglesa. Os agentes fugiram da linguagem compreensível e inventaram novos códigos para si mesmos”, disse o cientista Dhruv Batra, da FAIR, em entrevista ao Fast Co.

Em uma das conversas, por exemplo, um agente dizia “Bolas tenho zero para mim para mim para mim para mim para mim para mim…”, ao que que o outro respondia “eu eu posso eu eu eu tudo mais”.

“É como se eu dissesse um artigo cinco vezes, isso quisesse dizer que quero cinco cópias daquele item. Não é tão diferente da forma como comunidades de humanos criam atalhos [de linguagem]”, explicou Batra. O Facebook então optou por encerrar os testes com esse projeto.

Histórico

Não é a primeira vez que algo do tipo acontece. No início de 2016, a Microsoft lançou a Tay, um bot do Twitter que ganhava repertório conforme interagia com os usuários da rede social. Deu ruim: em menos de 24 horas, a robô tinha se transformado em uma persona racista e xenófoba, fazendo várias afirmações obscenas, algumas inclusive com apologia ao nazismo. A empresa a desativou logo em seguida.

Cientistas como Neil deGrasse Tyson e Stephen Hawking assinaram uma carta pedindo cautela com projetos de inteligência artificial. “A inteligência artificial pode ser desenvolvida para ter qualquer tipo de incentivo ou objetivo”, disse Stephen Hawking em uma sessão de perguntas e respostas do Reddit. “No entanto, como foi enfatizado pelo cientista Steve Omohundro, uma tecnologia extremamente inteligente provavelmente desenvolverá um ímpeto próprio para sobreviver e irá atrás do máximo de recursos possíveis para alcançar seus próprios objetivos.”

Esta reportagem foi publicada inicialmente no site da revista Galileu, em 31 de julho de 2017.

Foto de Possessed Photography na Unsplash